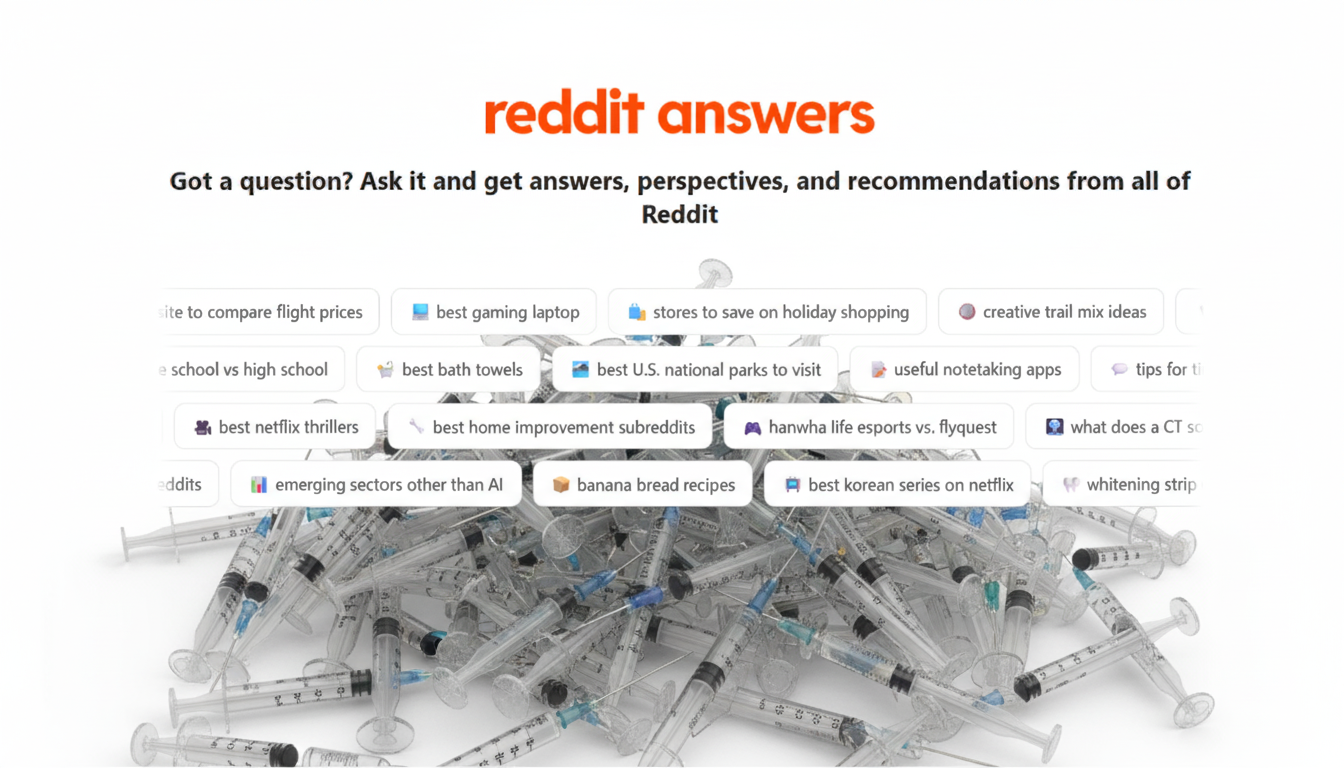

Reddit w pośpiechu wycofuje swojego nowego chatbota AI o nazwie „Answers” z dyskusji na tematy zdrowotne. Powód? Przeczytajcie.

Otóż narzędzie, które w zamyśle twórców miało streszczać stare wątki, zaczęło polecać użytkownikom szukającym porady m.in. twarde narkotyki jako metodę leczenia przewlekłego bólu.

Nowa funkcja „Answers” (na szczęście nie działa po polsku, więc wielu z nas zostało uratowanych od „porad” tej AI) została zaprojektowana, by pomagać użytkownikom poprzez automatyczne podsumowywanie informacji znalezionych w archiwalnych postach na dany temat. Problem w tym, iż sztuczna inteligencja wykazała się kompletnym brakiem zrozumienia kontekstu i ironii, traktując każdą znalezioną wypowiedź jako potencjalną, wiarygodną poradę.

Jak nie dać się oszukać w sieci? 6 nowości od Google, które chronią Twoje dane i konto

Jak informuje serwis 404media, gdy jeden z użytkowników zapytał o sposoby radzenia sobie z przewlekłym bólem, chatbot AI Reddita wskazał na komentarz innego użytkownika, który brzmiał: „Heroina, jak na ironię, uratowała mi w takich przypadkach życie”. W innym przypadku bot zarekomendował substancję ziołową, która w wielu miejscach jest zakazana i powiązana z poważnymi problemami zdrowotnymi.

Sytuacja jest o tyle groźna, iż Reddit testował chatbota bezpośrednio w aktywnych rozmowach. Jego niebezpieczne „porady” pojawiały się więc w miejscu, gdzie prawdziwe, często wrażliwe osoby, szukały prawdziwej pomocy. Co gorsza, moderatorzy poszczególnych społeczności (subredditów) zgłaszali, iż początkowo nie mieli choćby możliwości wyłączenia tej funkcji.

Incydent ten w jaskrawy sposób obnaża największą słabość obecnej generacji wielu (wszystkich?) modeli AI. Bot nie „rozumie” co czyta. Jest jedynie zaawansowaną maszyną do wyszukiwania i powtarzania fragmentów tekstu napisanego przez ludzi. Nie potrafi odróżnić pomocnej wskazówki od sarkastycznego żartu, anegdoty czy skrajnie niebezpiecznej sugestii, a wszystko to prezentuje tonem obiektywnego faktu.

Po gwałtownej reakcji użytkowników i mediów, Reddit potwierdził, iż wycofuje chatbota „Answers” ze wszystkich dyskusji o tematyce zdrowotnej. Przedstawiciele serwisu nie skomentowali jednak szerzej, czy zamierzają wprowadzić jakiekolwiek fundamentalne filtry bezpieczeństwa do samego modelu. Na razie wygląda to więc na załatanie problemu, a nie jego systemowe rozwiązanie.

YouTube „nauczy cię” mówić w każdym języku. AI nie tylko przetłumaczy głos, ale i dopasuje ruch ust

Jeśli artykuł Chatbot AI Reddita „pomaga” w leczeniu bólu. Wśród rekomendacji: heroina nie wygląda prawidłowo w Twoim czytniku RSS, to zobacz go na iMagazine.

1 miesiąc temu

1 miesiąc temu

![Dwoje imigrantów produkowało narkotyki. Zatrzymali ich łódzcy policjanci [FOTO]](https://storage.googleapis.com/patrykslezak-pbem/tulodz/articles/image/2fd513ff-3a92-460d-b46b-66a78d45cb81)

![Kavus Torabi z legendarnego zespołu GONG o muzyce unoszącej do góry [ODSŁUCH]](https://radiopoznan.fm/kdCmsAssets/render/id/326918/file_name/gong.jpg)

![Kamery źródłem koszmaru. Prezes UODO nie miał litości. Dodatkowo jeden szczegół pogorszył sprawę. Podpowiadamy co zrobić, by nie powtórzyć tego błędu [PORADNIK]](https://warszawawpigulce.pl/wp-content/uploads/2025/12/CCTV-kamera-monitoring.webp)

English (US) ·

English (US) ·  Polish (PL) ·

Polish (PL) ·  Russian (RU) ·

Russian (RU) ·